教师节原来是5月1日?中文增强的Llama 2大语言模型告诉您真相!

Llama 2 的中文场景问题

作为 AI 领域最强大的开源大模型,Llama 2 是基于2万亿 token 数据预训练,并在100万人类标记数据上微调得到对话模型。Llama 2 在包括推理、编程、对话和知识测试等许多基准测试中效果显著,能力接近于基于 GPT-3.5 的ChatGPT 的水平.

但是在 Llama 2的训练语料库中,中文占比较小,而且微调阶段也没有针对中文进行调优,所以当前 Llama 2 在中文问题回答上仍显不足。比如:

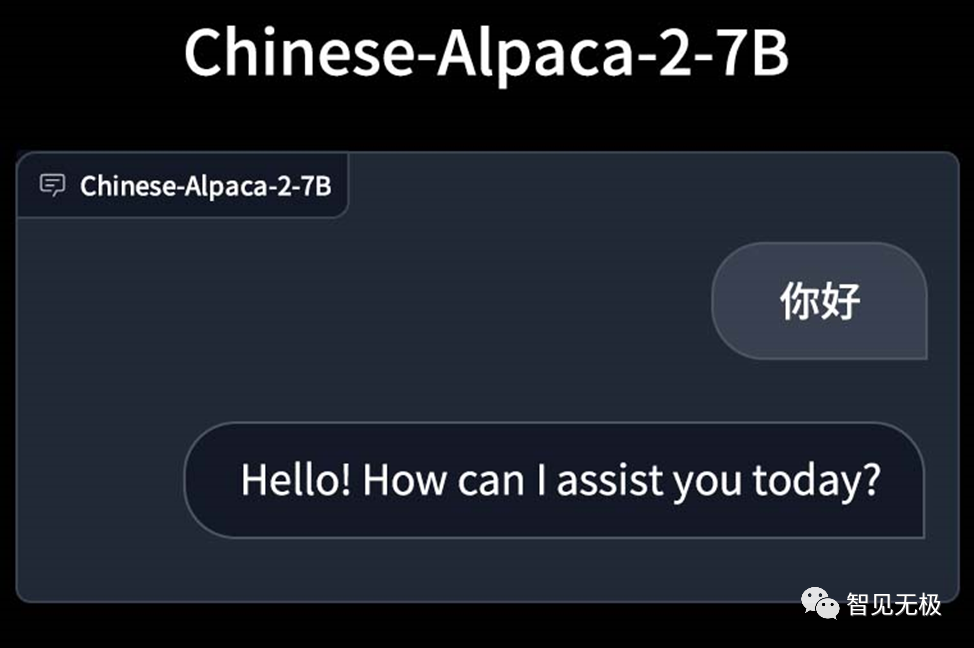

一个典型的表现就是给定中文问题时,模型还是会以英文回答。

或者以中英文混杂的形式回答问题,而且缺少与中文相关的知识。

Llama 2 的中文化解决方案

那有什么办法来优化 Llama 2 的中文能力?目前 Llama 2的中文化主要有两种方案:

第一种方案:

中文微调:基于已有的中文指令数据集,对模型进行指令微调,使得 Llama 2基础模型能够用中文问答。

优点:成本低,指令微调数据量小,需要的算力资源少,能够快速完成中文汉化,可以回答中文。

缺点:回答效果不正确。比如:

教师节是5月1日?小编赶紧上网查阅了教师节的来历。历史上教师节曾经是5月1日。

1951年,中华人民共和国教育部和中华全国总工会共同商定,把5月1日国际劳动节作为中国教师节。但由于种种原因,执行的结果并不理想。

这种方案虽然经过中文数据集的微调,可以用中文回答,但是缺乏足够多的中文语料库,回答的内容不太令人满意。所以中文微调方案是治标不治本。

第二种方案:

中文预训练:基于大规模中文语料库,从预训练开始做起。

优点:不仅可以回答中文,还能根据自身掌握的中文知识来理解和推理后做出合理的回答。比如:

细心的同学是不是发现这个大语言模型输出的最后一段话(总之...),好像有点不太对劲?发现的话可以给小编留言喔。

缺点:训练成本非常高!不仅需要大规模高质量的中文数据,也需要大规模的GPU 算力资源,训练周期也比较长。

本期智见无极推荐的中文增强 Llama 2 大语言模型是采用第二种方案中文预训练,它针对 Llama 2 基础模型扩充了新版中文词表,使用了大规模中文数据进行增量预训练,可以使用个人电脑的 CPU/GPU 快速在本地进行大模型量化和部署。不仅可以用中文回答,还能根据上下文中文给出较为合理的回复。

现在就跟随小编来智见无极 AI 课程实践环境来学习和体验中文增强大语言模型,看看它的中文能力到底有多厉害!